简介

通常在计算机视觉的深度学习算法中,Attention机制基本思想是让系统学会注意力,可以自动关注那些我们希望它关注的重点信息。

Attention

通常Attention机制被分为soft attention和hard attention,目前接触的算法通常都是soft attention机制。

Soft Attention

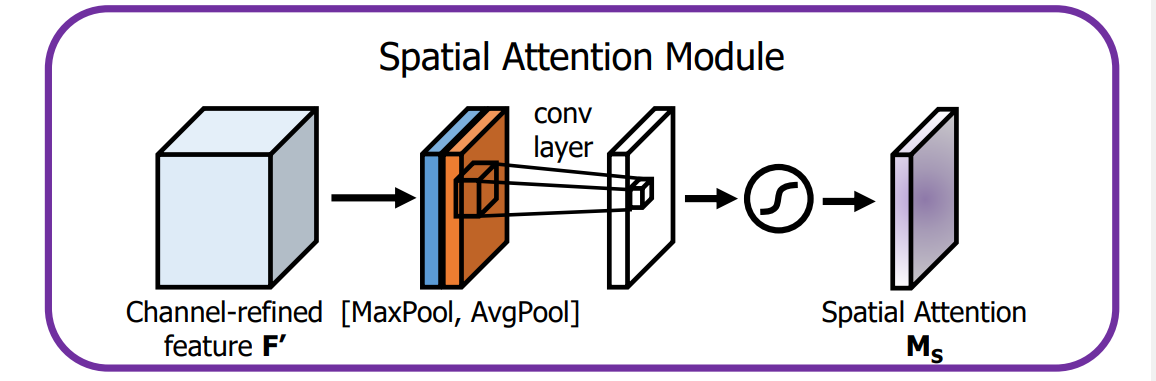

空间域

空间注意力表现在模型对于图像的不同位置的关注程度不同。当特征图大小为 H×W×C,空间注意力对应着大小为H×W的矩阵,该矩阵的每个位置对原特征图对应位置的像素来讲就是一个权重,pixel-wise multiply。

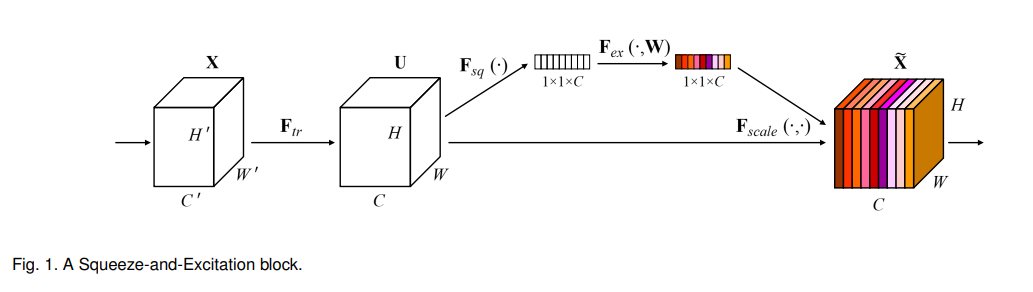

通道域

这种注意力主要分布在channel中,相当于对图像的不同通道的关注程度不同。当特征图大小为 H×W×C,通道注意力对应着大小为1×1×C的矩阵,每个位置对应原channel图像全部像素的一个权重,channel-wise multiply。